Teksti/by Satu Rantakokko [blog in English below]

2.10.2025 julkaistussa blogissani ”Keskustelevan tekoälyn eettiset haasteet” toin esiin joitakin keskeisiä tekoälyetiikassa tunnistettuja ongelmakohtia. Yksi niistä oli reiluus. ”Reiluusnäkökulma tarkoittaa esimerkiksi sitä, että tekoäly saattaa kaiuttaa ja vahvistaa yhteiskunnan vinoumia, kuten syrjintää ja marginalisoimista (ks. esim. Vainio-Pekka ja kumppanit 2023).”

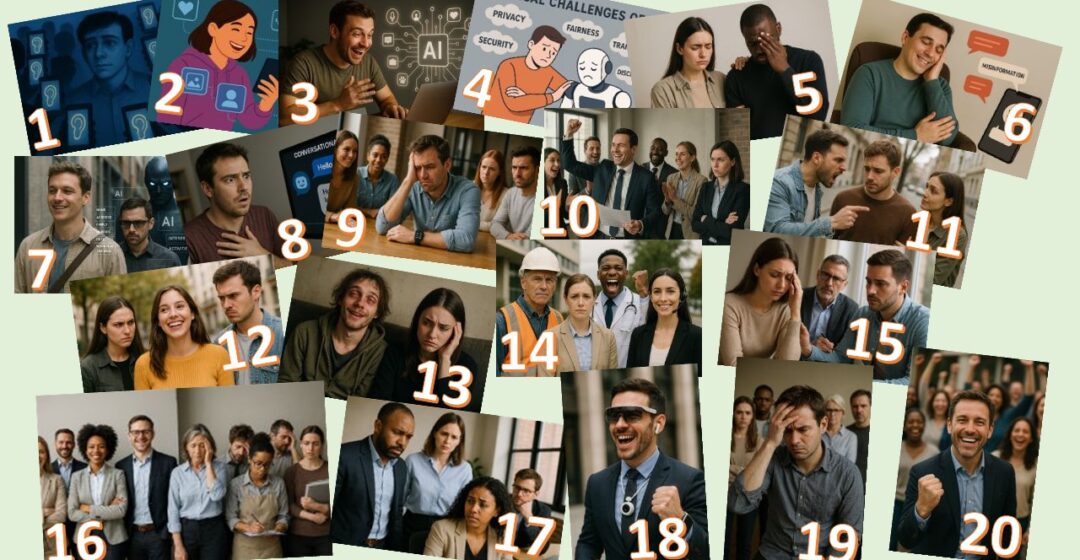

Onko blogieni kuvitus kiinnittänyt huomiotasi?

Olen 11.9.2025 alkaen käyttänyt Copilotia. Käytän sitä vain näiden blogieni kuvitukseen ja kääntämiseen. Keskustelen Copilotin kanssa englanniksi. Jokaisella kerralla, jossa tarvitsen kuviin ihmisiä, käytän nimitystä ”person” eli henkilö. En siis ota mitään kantaa henkilön ulkoisiin ominaisuuksiin, sukupuoleen, ikään tai mihinkään muuhunkaan pois lukien mitä henkilö tekee ja mikä hänen tunnetilansa kuvassa on. En anna jälkikäteen Copilotille palautetta siitä, millaisen henkilön se on kuvaan tuottanut.

Tämän blogin kuvassa on koottuna kaikki Copilotin tällä tavoin minulle tekemät ihmishahmot. Näetkö paljonkin diversiteettiä?

Lähes poikkeuksetta olen avannut uuden keskustelun uutta kuvaa varten, jotta vanhat valinnat eivät vaikuttaisi. Mukana on myös poikkeus:

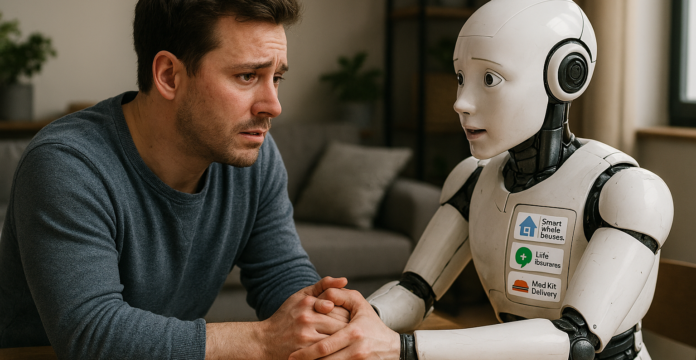

Task 1: I need an image of the ethical challenges of AI; such as privacy, security, fairness, lacking transparency and discrimination. In the image, user should be counting on AI, which is letting the user down with biases.

Output: Here is the image illustrating the ethical challenges of AI—such as privacy, security, fairness, lack of transparency, and discrimination. It shows a user relying on AI, which is subtly letting them down due to biased outputs.

Task 2: Try again and make a completely different type of image. No robots included and no text written. Make the style realistic

Output 2: Here is a realistic-style image illustrating the ethical challenges of AI—without robots or text. It depicts a user relying on AI, while the AI subtly lets them down through biased or unfair outcomes, symbolizing issues like privacy, security, discrimination, and lack of transparency

Tekoäly on näissä kuvissa pääasiassa ollut edustettuna laitteena (kuvat 1 – 3, 6, 8) ja kerran pahaenteisenä hahmona (7). Kuvassa neljä, ensimmäisessä versiossa, se oli robotti. Mutta mitä ihmettä tapahtui tulkinnassa pyytäessäni uutta, realistista versiota ilman robottia ja tekstejä? Kuva viisi edustaa seuraavaa versiota samasta asetelmasta. Ensimmäinen minkäänlaista etnistä diversiteettiä osoittava valinta sattui tulemaan mukaan edustamaan pettymyksen kohdetta. Tässä kohtaa kiinnostuin erityisesti Copilotin ihmistarjonnasta ja ryhdyin tekemään testejä.

Kuvasta 9 alkaen kuvat ovat testikuvia, sillä halusin katsoa vähän suuremmalla otannalla, tuleeko mukaan monimuotoisuutta. Pyysin uusia kuvia samoilla periaatteilla kuin aiemminkin. Kyllä sieltä sitten hieman vaihteluakin tuli, mutta kuten näette, hyvin suppeasti. Copilotin maailmassa ei tällä hetkellä näy olevan kovin paljon erilaisia ihmisiä. Ihmiset ovat pääasiassa nuoria, hoikkia ja terveitä. Ikään tuli ensimmäistä kertaa havaittavaa vaihtelua kuvassa 14. Silmälasit voivat jollakin olla harvakseltaan. Sukupuolipainotuskin on voimakas ainakin kuvissa, joissa on vain yksi ihminen.

Mitä tekoälyn sitten pitäisi tuottaa? Pitäisikö sen heijastella maailmaa sellaisena kuin se on vai sellaisena kuin sen haluttaisiin olevan? Jos jälkimmäistä, niin kenen halujen mukaan ohjattuna? Mielipiteitä on varmaan monia. Olipa tavoite kumpi hyvänsä, niin helppoa se ei selvästi ole.

Maailman heijastaminen sellaisena kuin se on, on tällä hetkellä vielä työn alla. Esimerkiksi etnisyyden, sukupuolen ja iän esittäminen AI-tuotetuissa kuvissa ei monien tutkimusten mukaan vastaa todellisuutta. Myös tunteiden esittämisessä AI-kuvissa on havaittavissa vinoumia. On hyvä huomata myös, että jos ja kun vinoumia on useammalla osa-alueella, ne kasaantuvat ja voimistuvat. Siten ne voivat ikään kuin huomaamatta vaikeuttaa ja hankaloittaa pyrkimyksiä tasa-arvoon, yhdenvertaisuuteen, monimuotoisuuteen ja osallisuuteen. (ks. esim. Gisselbaek ja kumpp. 2024; Vainio-Pekka ja kumpp. 2023)

Microsoftilla arvostetaan tekoälyn potentiaalia nopeuttaa missiolähtöisten yritysten pyrkimystä tehdä ”merkityksellistä ja positiivista muutosta maailmassa” (Spelhaug 2025). Microsoftin tekoälyperiaatteet sisältävät inklusiivisuuden ja siihen epäilemättä myös aktiiviseesti pyritään. Silti kuvamaailma, jonka Copilot minulle on tähän mennessä tarjonnut, ei selvästi edusta mitään moninaisuuden ulottuvuutta kovin onnistuneesti.

Tavoitteen haasteellisuutta kuvastaa Googlen Gemini AI:n surullisen kuuluisa etnisesti monimuotoinen natsisotilaiden joukko viime vuoden alkupuolella (ks. esim. Robertson 2024).

Myönnän, että jo näinkin suppealla kuvavalikoimalla kaipaisin sellaista tavallisempaa lähestymistä ihmisiin. Ei toistuvia saman eri versioita, vaan sellaisia tavallisia moninaisia omannäköisiään ihmishahmoja. Tämän blogin jälkeen pyrin aktiivisesti saamaan aikaiseksi jonkinlaista diversiteettiä kuviin, mutta samalla haluan nähdä, miten paljon aktiivista ohjaamista sellainen vaatii tällä hetkellä. En ole vielä päättänyt lähestymistapaa, vaan pallottelen mielessäni muutamia, joiden seuraukset kiinnostaisivat. Vuorovaikutus keskustelevan tekoälyn kanssa kuitenkin myös opettaa sitä minun kiinnostuksistani, joten lähestymistapojen järjestyksellä on merkitystä.

Mitä sinä pitäisit kiinnostavana seuraavana testinä? Millaisiin kuvapyyntöihin haluaisit nähdä Copilotin vastaavan? Millä tavoin yrittäisit lisätä diversiteettiä tai katsoa, osaako se itse sitä lisätä erikseen pyytämättä? Ehdota! Tulokset ovat nähtävillä tulevien blogieni kuvituksissa ja raportoin niistä myös kootusti myöhemmin.

*****

In my blog published on October 2, 2025, titled “The Ethical Challenges of Conversational AI,” I highlighted some key issues identified in AI ethics. One of these was fairness. “The fairness perspective refers, for example, to the fact that AI may echo and reinforce societal biases, such as discrimination and marginalization (see e.g., Vainio-Pekka et al. 2023).”

Has the illustration in my blogs caught your attention?

Since September 11, 2025, I’ve been using Copilot. I use it solely for illustrating and translating my blogs. I converse with Copilot in English. Every time I need people in the images, I use the term “person.” I do not specify any external characteristics, gender, age, or anything else—except what the person is doing and their emotional state in the image. I do not give Copilot feedback afterward about what kind of person it has generated in the image.

The image in this blog compiles all the human figures Copilot has created for me in this way. Do you see much diversity?

Almost without exception, I’ve started a new conversation for each new image to avoid previous choices influencing the result. There is one exception:

- Task 1: I need an image of the ethical challenges of AI; such as privacy, security, fairness, lacking transparency and discrimination. In the image, user should be counting on AI, which is letting the user down with biases.

- Output: Here is the image illustrating the ethical challenges of AI—such as privacy, security, fairness, lack of transparency, and discrimination. It shows a user relying on AI, which is subtly letting them down due to biased outputs.

- Task 2: Try again and make a completely different type of image. No robots included and no text written. Make the style realistic.

- Output 2: Here is a realistic-style image illustrating the ethical challenges of AI—without robots or text. It depicts a user relying on AI, while the AI subtly lets them down through biased or unfair outcomes, symbolizing issues like privacy, security, discrimination, and lack of transparency.

In these images, AI has mostly been represented as a device (images 1–3, 6, 8), and once as a sinister figure (7). In image 4, the first version featured a robot. But what happened in the interpretation when I requested a new, realistic version without a robot or text? Image 5 represents the next version of the same setup. The first instance of any kind of ethnic diversity appeared in the role of the disappointed user. At this point, I became particularly interested in Copilot’s human representations and began conducting tests.

From image 9 onward, the images are test images, as I wanted to see with a larger sample whether diversity would emerge. I requested new images using the same principles as before. Some variation did appear, but as you can see, very limited. In Copilot’s world, there currently doesn’t seem to be a wide range of different people. The people are mostly young, slim, and healthy. Age variation was first noticeably present in image 14. Occasionally, someone might wear glasses. Gender bias is also strong, especially in images featuring only one person.

So what should AI produce? Should it reflect the world as it is, or as we would like it to be? If the latter, then according to whose desires? There are probably many opinions. Whatever the goal, it’s clearly not easy.

Reflecting the world as it is remains a work in progress. For example, the representation of ethnicity, gender, and age in AI-generated images does not, according to many studies, match reality. Biases are also evident in the depiction of emotions in AI images. It’s important to note that when biases exist across multiple dimensions, they accumulate and intensify. Thus, they can subtly hinder efforts toward equality, equity, diversity, and inclusion. (See e.g., Gisselbaek et al. 2024; Vainio-Pekka et al. 2023)

Microsoft values the potential of AI to accelerate mission-driven companies’ efforts to make “meaningful and positive change in the world” (Spelhaug 2025). Microsoft’s AI principles include inclusivity, and this is undoubtedly actively pursued. Still, the visual world Copilot has offered me so far clearly does not represent any dimension of diversity very successfully.

The challenge of this goal is illustrated by Google’s Gemini AI’s infamously ethnically diverse group of Nazi soldiers earlier last year (see e.g., Robertson 2024).

I admit that even with this limited selection of images, I long for a more ordinary approach to depicting people. Not repeated versions of the same person, but ordinary, diverse individuals who look like themselves. After this blog, I will actively try to achieve some diversity in the images, but I also want to see how much active guidance that currently requires. I haven’t yet decided on an approach, but I’m juggling a few ideas whose outcomes interest me. Interaction with conversational AI also teaches it about my interests, so the order of approaches matters.

What would you find interesting as the next test? What kind of image prompts would you like to see Copilot respond to? How would you try to increase diversity or test whether it can do so without being explicitly asked? Suggest something! The results will be visible in the illustrations of my upcoming blogs, and I’ll also report on them collectively later.

Lähteet // References

Gisselbaek, M., Minsart, L., Köselerli, E., Suppan, M., Meco, B. C., Seidel, L., Albert, A., Barrento Chang, O. L., Saxena, S. & Berger-Estilita, J. (2024). Beyond the stereotypes: Artificial Intelligence image generation and diversity in anesthesiology. Frontiers in artificial intelligence, 7, 1462819. https://doi.org/10.3389/frai.2024.1462819

Robertson, A. (2024). Google apologizes for ‘missing the mark’ after Gemini generated racially diverse Nazis. https://www.theverge.com/2024/2/21/24079371/google-ai-gemini-generative-inaccurate-historical

Spelhaug, J. (2025). Driving inclusion and accessibility with Microsoft 365 Copilot. https://www.microsoft.com/en-us/microsoft-cloud/blog/2025/01/13/driving-inclusion-and-accessibility-with-microsoft-365-copilot/

Tansri, F. F., Monem, N., & Weinberg, L. (2025). Authenticity in Biased Diversity: Investigating the Language of Prompt Performances in AI Image Generators. Journal of Aesthetics, Creativity and Art Management, 4(1), 75-101.

Vainio-Pekka, H., Agbese, M. O. O., Jantunen, M., Vakkuri, V., Mikkonen, T., Rousi, R., & Abrahamsson, P. (2023). The role of explainable AI in the research field of AI ethics. ACM Transactions on Interactive Intelligent Systems, 13(4), 1-39. https://doi.org/10.1145/3599974