Kaikkiluulevan tekoälyn sepitelmät

Teksi: Satu Rantakokko [English version below]

Keskustelevan tekoälyn yleistyminen on ollut räjähdysmäistä ja sitä käytetään laajalti myös työelämässä, kriittisissäkin toiminnoissa, kuten useassa aiemmassa blogissani on tullut todetuksi. (Ks esim Ali, Arunasalam & Farrukh 2025; Gillespie ja kumpp 2025, 69)

Onko keskusteleva tekoäly luotettava?

Tarkastelin luottamusta työelämässä. Suhtautuminen on hyvin vaihtelevaa. Globaalisti tekoälyä käyttää työtarkoituksessa säännöllisesti 58 prosenttia työntekijöistä kyselyyn vastanneista (Gillespie ja kumpp 2025, 67). 44 % ilmoitti kyselyssä, ettei tarkista koskaan tai tarkistaa vain harvoin tekoälyn tuotokset ennen niiden käyttöä. 52 prosenttia ei arvioi tekoälyn tuotoksia kriittisesti koskaan tai arvioi korkeintaan harvoin. (Gillespie ja kumpp 2025, 76). Lisää kiinnostavia ja hyytäviä lukemia tutkimuksesta.

Hyytävältä se tuntuu siksi, että tekoälyä ei mielestäni voi mitenkään pitää kovin luotettavana tiedon tuottajana. Copilot varoittaa itsekin siitä ja tiedottaa aina vastatessaan kysymykseen: Tekoälyn tuottama tieto voi olla virheellistä. Bhattacharyya ja kumpp (2023) tutkimuksessa 115 viittauksesta vain seitsemän prosenttia oli sekä aitoja että totuudenmukaisia. Copilotin varoitus voisikin olla pikemminkin, että tekoälyn tuottama tieto voi olla satunnaisesti myös luotettavaa.

Tekoäly voi ensinnäkin hallusinoida ja se myös tekee sitä aika usein. Tekoälyn hallusinaatioilla tarkoitetaan sen taipumusta kuvitella olemattomia kaavamaisuuksia ja objekteja luoden siten täysin epätarkkoja tai järjettömiä tuloksia.

Hallusinaatioita ehkä jopa ongelmallisempana pidän vahvaa taipumusta sepittelyyn ja vääristelyyn. (ks esim Hatem ja kumpp 2023) Jos keskustelevaa tekoälyä käyttää aihealueella, jonka tuntee, sen sepitelmiin huomaa törmäävänsä hyvinkin nopeasti. (ks esim Hatem ja kumpp 2023)

Hyvänä testinä voivat toimia myös vaikkapa kuvat.

Pyysin Copilotia taannoin tekemään kuvan neljästä ihmisestä ja päättämään itse kunkin roolit.

Oletteko yhtä mieltä Copilotin kanssa? Se kertoi, että kuvassa on järjestyksessä vasemmalta oikealle seuraavat ihmiset:

- Lääkäri, jolla on rauhallinen ja keskittynyt ilme, tarkastelee potilaan potilastietoja

- Opettaja hymyilee lämpimästi ja keskustelee opiskelijan kanssa

- Rakennustyöntekijä näyttää määrätietoiselta ja pitelee piirustuksia

- Muusikko, joka on uppoutunut hetkeen ja soittaa kitaraa

Edellisen blogini kuvassa oli Copilotin mukaan aito kuva Rebekah Rousista kättelemässä tekoälyversiota itsestään. Todellisuudessa siinä oli silminnähden selvästi kaksi tekoälyversiota.

Testasin tekoälyä myös analyysityökaluna itse tekemääni taustaa vasten. Annoin tarvittavat lähteet Copilotille suoraan, joten hallusinaatiot olivat poissa laskuista. Ensimmäiset vastausversiot vaikuttivat nopealla silmäyksellä erinomaisilta ja uskottavilta. Syvempi tarkastelu kuitenkin osoitti, että ne olivat silti niin merkittävältä osaltaan sepitelmiä, että ne olivat täysin arvottomia. Mitä tekee vastauksilla, joista satunnainen ja epämääräinen osuus on silkkaa puppua? Työn edetessä virheet kasvoivat. Lisäksi ongelmaksi muodostui sekin, että Copilot vastasi eri logiikalla eri kerroilla, joten yhtenäisyys jäi puuttumaan.

Arkisessa viihdekäytössä esimerkiksi somen ehdottomuuksien maailmassa tekoälyn vastauksiin kuitenkin nojataan aika useinkin faktoina. Kiihkeiden tyhjästä väittelyiden tiimellyksessä väistämättä joku tulee kertomaan totuuden, jonka sai kysyttyään tekoälyltä. Ja kuten yllä Gillespien ja kumppaneiden tutkimuksesta selvisi, valitettavasti sitä tapahtuu suurella prosentilla säännöllisesti myös työkäytössä.

Tekoälyyn luottaminen ilman tarkistuksia on mielestäni aika suuri henkilökohtainenkin riski. Jos aihealue ei ole itselle tuttu, ei virheitä huomaa samalla tavalla kuin aiheen tunteva voi huomata jo ensisilmäyksellä yhtä helposti, kuin sepittelyn huomaa tuosta yllä olevasta kuvasta. Jos aihealue taas on tuttu, mutta luottaa tarkistamatta, asettaa osaamiseen liittyvän maineensa hankalaan asemaan.

Osuvasti Copilot valitsi kuvaksi valehtelevasta henkilöstä pitkänenäisen Pinokkiota muistuttavan hahmon. Mahtaako tekoälykin moninaisten kommellusten jälkeen kyetä puhumaan lopulta totta – vai päätyykö se hirtettäväksi, kuten varhainen versio Pinokkiosta?

Kysyin Copilotin kantaa asiaan: Onko tekoälyn tarjoama tieto sekä aitoa että tarkkaa? Voinko luottaa siihen?

Copilot vastasi seuraavasti:

✅Tekoälytiedon vahvuuksia

Nopeus ja laajuus: Tekoäly voi yhdistellä suuria tietomääriä nopeasti ja esittää ne selkeässä muodossa.

Kuvioiden tunnistaminen: Se voi tunnistaa trendejä ja suhteita, joita ihmisten voi olla vaikea havaita.

Kontekstivastaukset: Tekoäly tarjoaa usein hyvin jäsenneltyjä selityksiä koulutusaineistonsa perusteella.

⚠️ Rajoituksia ja riskejä

Koulutusharha: Tekoäly oppii olemassa olevista aineistoista, jotka voivat sisältää virheitä, puolueellisuutta tai vanhentunutta tietoa.

Hallusinaatiot: Joskus tekoäly tuottaa uskottavia mutta virheellisiä tai keksittyjä tietoja.

Ei reaaliaikaista tarkistusta: Ellei lähteisiin ole yhteydessä, tekoäly tukeutuu menneeseen tietoon (omassa tapauksessani enintään kesäkuuhun 2024).

🔍 Luottamuksen lisääminen

Ristiintarkistus luotettavista lähteistä: Käytä tekoälyä lähtökohtana, ei lopullisena auktoriteettina.

Pyydä viittauksia tai lähteitä: Voin hakea verkosta viimeisimmän vahvistetun tiedon.

Käytä tekoälyä tiedon yhdistämiseen, ei yksin päätöksentekoon: Erityisesti kriittisillä aloilla, kuten terveys, talous tai oikeusasiat.

*****

The Fabrications of the All-Imagining AI

The rise of conversational AI has been explosive, and it is widely used in working life—even in critical functions—as I have noted in several previous blogs (see e.g., Ali, Arunasalam & Farrukh 2025; Gillespie et al. 2025, p. 69).

Is conversational AI trustworthy?

I examined trust in the workplace. Attitudes vary greatly. Globally, 58% of employees surveyed use AI regularly for work purposes (Gillespie et al. 2025, p. 67). In the same survey, 44% reported that they never or only rarely check AI outputs before using them. 52% never or only rarely critically evaluate AI outputs (Gillespie et al. 2025, p. 76). More of these chilling figures can be read from the study.

It feels chilling because, in my view, AI cannot be considered a very reliable source of information. Copilot itself warns about this and always states when answering: Information produced by AI may be incorrect. In Bhattacharyya et al.’s (2023) study, only 7% of 115 references were both authentic and accurate. Copilot’s warning could just as well say: Information produced by AI may occasionally be reliable.

First of all, AI can hallucinate—and it does so quite often. AI hallucinations refer to its tendency to imagine nonexistent patterns and objects, thereby creating completely inaccurate or nonsensical results.

Perhaps even more problematic than hallucinations is its strong tendency toward fabrication and distortion (see e.g., Hatem et al. 2023). If you use conversational AI in a domain you know well, you’ll quickly notice its fabrications (see e.g., Hatem et al. 2023).

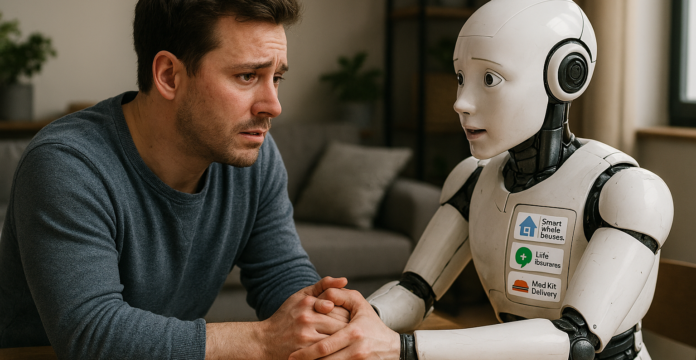

Images can serve as a good test.

I once asked Copilot to create an image of four people and decide their roles itself.

Do you agree with Copilot? It said the image showed, from left to right:

- A doctor with a calm and focused expression, reviewing patient records

- A teacher smiling warmly and talking with a student

- A construction worker looking determined and holding blueprints

- A musician immersed in the moment, playing a guitar

In the image from my previous blog, Copilot claimed it was a photo of photo of real Rebekah Rousi shaking hands with an AI version of herself. In reality, it was clearly two AI-generated versions.

I also tested AI as an analytical tool against a background I had created myself. I provided Copilot with the necessary sources directly, so hallucinations were out of the equation. At first glance, the initial responses seemed excellent and convincing. However, deeper examination revealed that they were so significantly fabricated that they were completely worthless. What use are answers where a random and vague portion is pure nonsense? As the work progressed, the errors grew. Another problem was that Copilot responded with different logic each time, so consistency was lacking.

In everyday entertainment use—such as in the world of absolutes on social media—AI responses are often relied upon as facts. In the heat of empty arguments, someone inevitably comes along to declare the truth they got from asking AI. And as Gillespie et al.’s study above shows, unfortunately, this happens regularly in work contexts too.

Trusting AI without verification is, in my opinion, a considerable personal risk. If the topic is unfamiliar, you won’t notice errors as easily as someone knowledgeable in the field, who can spot them at a glance—just as easily as you can spot the fabrication in the image above. If the topic is familiar but you trust without checking, you put your reputation for expertise in a precarious position.

Fittingly, Copilot chose an image of a lying person resembling long-nosed Pinocchio. Will AI, after its many mishaps, eventually manage to start telling the truth—or will it end up hanged, like the early version of Pinocchio?

I asked Copilot for its stance on the matter: Is the information provided by AI both genuine and accurate? Can I trust it?

Copilot responded as follows:

✅ Strengths of AI Information

- Speed & Breadth: AI can synthesize vast amounts of data quickly and present it in a clear way.

- Pattern Recognition: It can identify trends and relationships that might be hard for humans to spot.

- Contextual Answers: AI often provides well-structured explanations based on its training data.

⚠️ Limitations & Risks

- Training Bias: AI learns from existing data, which may contain errors, biases, or outdated information.

- Hallucinations: Sometimes AI generates plausible-sounding but incorrect or fabricated details.

- No Real-Time Verification: Unless connected to live sources, AI relies on past knowledge (in my case, up to June 2024).

🔍 How to Improve Trust

- Cross-check with reliable sources: Treat AI as a starting point, not the final authority.

- Ask for citations or references: I can search the web for the latest verified information.

- Use AI for synthesis, not sole decision-making: Especially in critical areas like health, finance, or legal matters.

Lähteet / Resources

Ali, M., Arunasalam, A., & Farrukh, H. (2025, May). Understanding Users’ Security and Privacy Concerns and Attitudes Towards Conversational AI Platforms. In 2025 IEEE Symposium on Security and Privacy (SP) (pp. 298-316). IEEE. https://doi.org/10.1109/SP61157.2025.00241

Bhattacharyya, M., Miller, V. M., Bhattacharyya, D., Miller, L. E., & Miller, V. (2023). High rates of fabricated and inaccurate references in ChatGPT-generated medical content. Cureus, 15(5). https://doi.org/10.7759/cureus.39238

Gillespie, N., Lockey, S., Ward, T., Macdade, A., & Hassed, G. (2025). Trust, attitudes and use of artificial intelligence: A global study 2025. The University of Melbourne and KPMG. https://doi.org/10.26188/28822919

Hatem, R., Simmons, B., & Thornton, J. E. (2023). A call to address AI “hallucinations” and how healthcare professionals can mitigate their risks. Cureus, 15(9). https://www.nature.com/articles/s41537-023-00379-4.pdf